Американские специалисты полагают, что это может стать следствием того, когда ядерные вооружения начнёт полностью контролировать искусственный интеллект. Машины смогут при определённых обстоятельствах просто выйти из-под контроля человека.

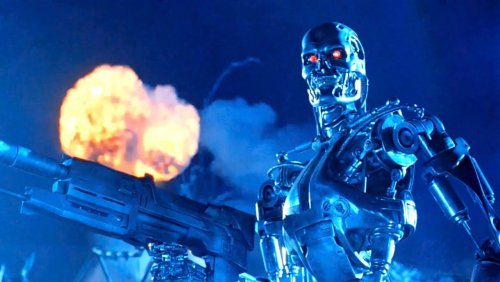

Таким образом, учёные-ядерщики США полагают, что миру грозит вполне реальная война «в стиле Терминатора». По крайней мере, таков вывод исследователей, работающих в Корнеллском университете.

Они уверены, что при растущем «уклоне автоматизации» машины станут способными «выходить из-под контроля». Более того, совершенно не исключено, что роботы, действительно, объявят войну всему человечеству.

Эксперты США высказали своё мнение о значительном отставании России и Китая по вооружениям. Следовательно, и Пекин, и Москва, зная об этом, начинают полагаться на применение новых военных технологий, в которых применяется искусственный интеллект. При этом, они совершенно не обращают внимания на появление «огромных рисков».

Судя по докладу, военные часто полностью уверены, что применение ИИ является достаточно безопасным путём. Однако, американские эксперты полагают, что «коварные риски» смогут проявиться, когда произойдёт непредусмотренная авария.

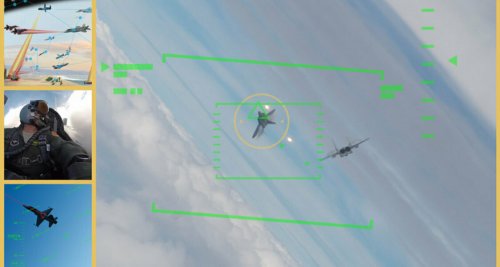

В особенности американцев беспокоит создание Россией и Китаем автономных необитаемых машин по доставке ядерного оружия до цели. Помимо того, они тревожатся и о том, что в системы по предупреждению о нападениях противника стал активно внедряться искусственный интеллект.

В качестве примера приводится то, что РФ уже приступила к разработкам «Посейдона», являющегося автономной ядерной торпедой с практически неограниченным сроком и радиусом своего действия.

Американских военных тревожит, что данный пример Москвы может оказаться «заразительным» и это станет тенденцией в создании новейших вооружений многими другими государствами.

В связи с этим, военные исследователи припомнили произошедший в 1983 году инцидент, когда между СССР и США могла разразиться ядерная война. Американцы предполагают, что мир был спасён лишь действиями советского офицера Станислава Петрова.

Он, якобы, не стал реагировать на сигнал о запуске ракет с американской территории, поняв, что тот был ложным, и не нажал «кнопку».

Правда здесь лишь в том, что сигналы о ложных запусках, действительно, периодически поступают. Однако, запустить ядерные ракеты или же, напротив, остановить команду на их запуск один человек совершенно не в состоянии.

Одновременно, учёные США признали, что внедрение автоматизации и интеллектуализации в системы, связанные с применением атомного оружия, вполне может привести к повышению их надёжности и стабильности работы.